2023. november 30. 09:08, Csütörtök

A tények összegzésekor a ChatGPT technológia az esetek körülbelül 3 százalékában kitalál dolgokat - derült ki egy új kutatásából. A Google rendszerének aránya 27 százalék volt.

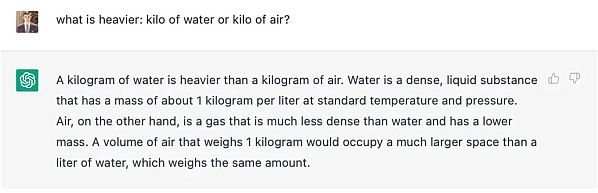

Amikor a San Franciscó-i OpenAI startup tavaly év végén bemutatta ChatGPT nevű online chatbotját, milliókat nyűgözött le, hogy emberhez hasonlóan válaszolt a kérdésekre, verseket írt és szinte bármilyen témáról beszélgetett. A legtöbben azonban csak lassan jöttek rá, hogy ez az újfajta chatbot gyakran kitalál dolgokat. Amikor a Google néhány héttel később bemutatott egy hasonló chatbotot, az ostobaságokat mondott a James Webb teleszkópról. Másnap a Microsoft új Bing chatbotja a Gapről, a mexikói éjszakai életről és Billie Eilish énekesnőről osztott meg mindenféle hamis információt. Márciusban a ChatGPT féltucatnyi hamis bírósági ügyet idézett, miközben egy 10 oldalas jogi beadványt írt, amelyet egy ügyvéd

benyújtott egy manhattani szövetségi bírónak.

Most egy új,

Vectara nevű startup, amelyet a Google korábbi alkalmazottai alapítottak,

azt próbálja kideríteni, hogy a chatbotok milyen gyakran térnek el az igazságtól. A vállalat

kutatásai szerint a chatbotok még az olyan helyzetekben is, amelyeket úgy terveztek, hogy ez ne történhessen meg, az esetek legalább 3 százalékában - de akár 27 százalékban is - kitalálnak információkat. A szakértők ezt a chatbot viselkedést "

hallucinációnak" nevezik. Lehet, hogy ez nem jelent problémát a chatbotokkal a saját számítógépükön bütykölő emberek számára, de komoly problémát jelent mindazok számára, akik ezt a technológiát bírósági dokumentumokkal, orvosi információkkal vagy érzékeny üzleti adatokkal használják.

Mivel ezek a chatbotok szinte bármilyen kérésre korlátlan számú módon válaszolhatnak, nem lehet egyértelműen meghatározni, hogy milyen gyakran hallucinálnak. "A világ összes információját meg kellene vizsgálni" - mondta Simon Hughes, a projektet vezető Vectara kutatója. Dr. Hughes és csapata arra kérte ezeket a rendszereket, hogy egyetlen, egyszerű, könnyen ellenőrizhető feladatot hajtsanak végre: foglaljanak össze a hírcikkeket. A chatbotok még ekkor is kitartóan kitalálták az információkat. "Megadtunk a rendszernek 10-20 tényt, és kértünk egy összefoglalót ezekről a tényekről" - mondta Amr Awadallah, a Vectara vezérigazgatója, a Google korábbi vezetője. "Az, hogy a rendszer még mindig képes hibákat bevezetni, alapvető probléma."

A kutatók érvelése szerint amikor ezek a chatbotok más feladatokat is ellátnak - a puszta összegzésen túl -, a hallucinációk aránya magasabb lehet. Kutatásuk azt is kimutatta, hogy a hallucinációs arányok nagymértékben eltérnek a vezető MI cégek között. Az OpenAI technológiáinál volt a legalacsonyabb, 3 százalék körüli arány. A Facebookot és az Instagramot birtokló Meta rendszerei 5 százalék körül mozogtak. A szintén San Francisco-i székhelyű OpenAI-rivális Anthropic által kínált Claude 2 rendszer 8 százalék fölött volt. A Google egyik rendszere, a Palm chat volt a legmagasabb, 27 százalékos.

Az Anthropic szóvivője, Sally Aldous elmondta: "Cégünk egyik fő célja, hogy rendszereink hasznosak, őszinték és ártalmatlanok legyenek, ami magában foglalja a hallucinációk elkerülését". A Google nem kívánt nyilatkozni, az OpenAI és a Meta pedig nem reagált a megkeresésekre. Ezzel a kutatással Dr. Hughes és Awadallah azt szeretné megmutatni az embereknek, hogy óvatosnak kell lenniük a chatbotoktól származó információkkal, sőt még a Vectara által a vállalkozásoknak értékesített szolgáltatással is. Sok vállalat kínál mostanában ilyen technológiát üzleti felhasználásra.

A kaliforniai Palo Altóban működő Vectara egy 30 fős startup, amely mögött

28,5 millió dolláros tőke áll. Egyik alapítója, Amin Ahmad, a Google korábbi mesterséges intelligencia kutatója 2017 óta foglalkozik ezzel a fajta technológiával, amikor a Google és néhány más vállalaton belül elterjedt a használata. Ahogy a Microsoft Bing kereső chatbotja a nyílt internetről tud információkat lekérdezni, a Vectara szolgáltatása egy vállalat privát e-mail-, dokumentum- és egyéb fájlgyűjteményéből tud információkat lekérdezni.

A kutatók azt remélik, hogy módszereik - amelyeket nyilvánosan megosztanak és folyamatosan frissíteni fognak - segítenek majd ösztönözni az iparágon belüli erőfeszítéseket a hallucinációk csökkentésére. Az OpenAI, a Google és mások különböző technikákkal igyekeznek minimalizálni a problémát, bár nem egyértelmű, hogy meg tudják-e szüntetni azt. "Egy jó analógia az önvezető autó" - mondta Philippe Laban, a Salesforce kutatója, aki régóta foglalkozik az ilyen jellegű technológiákkal. "Egy önvezető autót nem lehet megakadályozni abban, hogy balesetet szenvedjen. De megpróbálhatod elérni, hogy biztonságosabb legyen, mint egy emberi sofőr."

A ChatGPT-hez hasonló chatbotokat egy nagy nyelvi modellnek, LLM-nek nevezett technológia vezérli, amely hatalmas mennyiségű digitális szöveg, köztük könyvek, Wikipedia-cikkek és online csevegési naplók elemzésével tanulja meg a képességeit. Azáltal, hogy az LLM az összes adatban mintákat talál, megtanul egy bizonyos dolgot: kitalálni a következő szót egy szósorozatban. Mivel az internet tele van valótlan információkkal, ezek a rendszerek ugyanazokat a valótlanságokat ismétlik. Valószínűségekre is támaszkodnak: mennyi a matematikai esélye annak, hogy a következő szó a "drámaíró"? Időről időre rosszul tippelnek.

A Vectara új kutatása megmutatja, hogyan történhet ez meg. A hírcikkek összefoglalása során a chatrobotok nem ismétlik meg az internet más részeiről származó valótlanságokat, csak az összegzést rontják el. Az olyan vállalatok, mint az OpenAI, a Google és a Microsoft kifejlesztették a technológiáik pontosságának javítására szolgáló módszereket. Az OpenAI például emberi tesztelők visszajelzéseivel próbálja finomítani a technológiáját, akik értékelik a chatbot válaszait, elkülönítve a hasznos és igaz válaszokat a nem igaz válaszoktól. Ezután a rendszer a megerősítő tanulásnak nevezett technika segítségével heteket tölt a minősítések elemzésével, hogy jobban megértse, mi a tény és mi a fikció.

A kutatók azonban figyelmeztetnek, hogy a chatbot hallucináció nem könnyen megoldható probléma. Mivel a chatrobotok az adatok mintázataiból tanulnak és valószínűségek alapján működnek, legalábbis időnként nem kívánt módon viselkednek. Annak megállapítására, hogy a chatbotok milyen gyakran hallucináltak a hírcikkek összefoglalása során, a Vectara kutatói egy másik nagy nyelvi modellt használtak az egyes összefoglalók pontosságának ellenőrzésére. Ez volt az egyetlen módja annak, hogy ilyen nagyszámú összefoglalót hatékonyan ellenőrizzenek. James Zou, a Stanford informatika professzora szerint azonban ez a módszer egy kikötéssel járt. Az ellenőrzést végző nyelvi modell is hibázhat. "A hallucinációdetektort becsaphatják - vagy ő maga is hallucinálhat" - mondta.

Informatika és tudomány

Informatika és tudomány

Informatika és tudomány

Informatika és tudomány